Who Are You Talking to?

課題内容

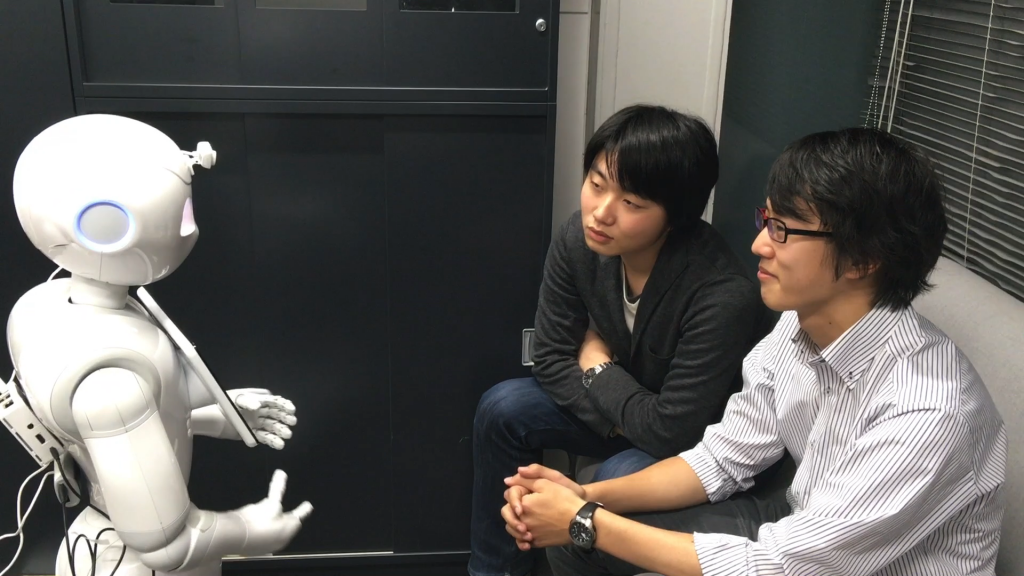

二人のユーザとPepperが会話をしている想定で,Pepperにインタラクションの状況を理解する様々な機能を追加する.

- 悲しい表情をしている人の方を向く機能

- 人が話していることを検知する機能

- 誰が話しているのかを推定する機能

- 人がPepperともう一人のユーザのどちらを見ているのかを推定する機能

- 「誰が誰に向かって話しかけているのか」を推定する機能 (extra課題)

…人が話している間,最も話者が向いていた方向の人(ロボット)が話しかけられている対象とみなす

実装環境

- Softbank Robotics 社 Pepper

- Choregraphe (GUIを使ってPepperのプログミング開発ができる)

- Python 2 (Choregrapheのプログラムをカスタマイズするのに使用)

目的

- 画像情報や音声情報からコミュニケーションに関する情報を取得する体験をする

背景

- ロボットが人とN対Nの対話をするには,人が誰に向けて話しているのかをロボットが認識する必要がある

- 既存研究では,視線(または視線の近似値として頭部の向き)や発話の韻律情報(ロボットに対してはゆっくり喋るなど),体の揺れ,発話内容などをもとに,人が誰に対して発話を行なっているかの推定が行われている.

- 新人課題では,もっとも古典的な手法として,発話中の視線情報をもとに受話者を推定するプログラムをNaoqi上に構築してもらう.