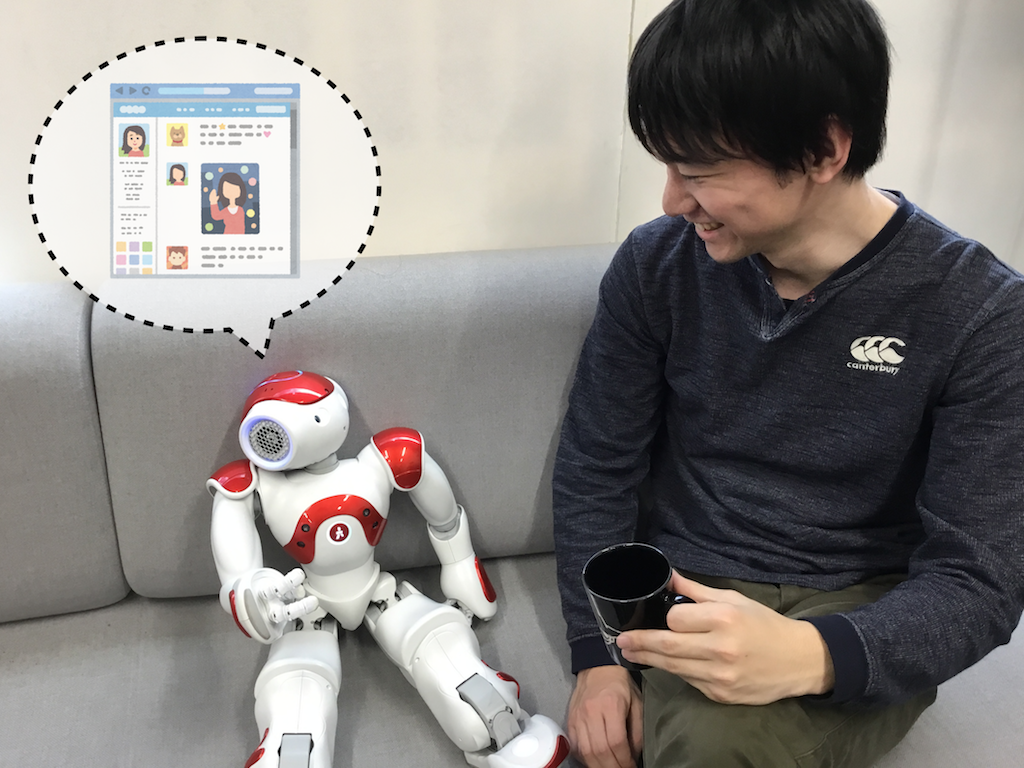

Our research focuses on creating a robotic system that aids human-to-human communication. The robot acts as a personal companion that understands the user’s emotions and helps express them alongside the user. First, the user’s facial expression is detected through a connected camera device and relays the retrieved information to a humanoid robot. The humanoid robot then performs physical gestures that match the detected emotion. By using this system, those who are unable to freely move their own bodies can add a physical component to their communication method. In this paper, we have determined the efficacy of translating detected facial expressions into robot movements. Through experiments and surveys, we determined whether our proposed ‘Ex-Amp Robot’ helped enhance the communication of a hypothetically tetraplegic user.

Robot Avatar for Enhancing the Communication of Physically Disabled Humans : Ai Kashii, Kazunori Takashio and Hideyuki Tokuda 25th IEEE International Symposium on Robot and Human Interactive Communication (RO-MAN 2016), Aug, 2016

The robot avatar proposed in this paper is a personal companion that captures users’ facial expressions and translates retrieved emotion data into gestures best suited to express the user’s emotion in real-time. This robot allows users to enjoy physical aspects of communication, as well as put an impact on parts of conversations to raise conversation quality. In this research, we have conducted experiments to validate the efficacy of translating facial expressions into robot movements.

Expression Amplifying Robot ~ 会話の中での表現力を増強するロボット ~ : 樫井亜依, 高汐一紀, 徳田英幸, 信学技報, vol. 116, no. 106, CNR2016-3, pp. 11-16, 2016年6月.

現在,様々なタイプのロボットが,あるものはコミュニケーションパートナとして,またあるものは労働力として,我々の日常生活を支えてくれている.コミュニケーションを支援するロボットの種類は多く,アバタ(アイデンティティの象徴)として機能するものもあれば,それ自身が会話相手として振る舞うロボットもある.本稿で我々は,H2Hのコミュニケーションを補助するロボットシステムEx-Ampを提案する.本ロボットシステムは,感情の表現力を増幅するロボットであり,ユーザの感情を理解するパーソナルロボットとして動作し,ユーザの側で,ユーザの代わりとなって感情を身体表現する.感情を身体表現することが困難なユーザも,本パーソナルロボットを使うことで,自身の感情表現の自由度を上げることが可能となる.今回,我々はスマートフォン上での表情検出機構と組み合わせ,検出された表情をロボットの動作トリガとして利用する機構を実装した.さらに,H2Hコミュニケーションにおける表現力向上の効力を,四肢麻痺状況のユーザを想定した評価実験を通して検証した.

MoNADによる鏡像認知ロボットのMindstorm EV3における実装 : nago

ロボット制作の学習を目的とし、参考書をもとに、鏡に写った像を自身だと判断できる鏡像認知ロボットをMindstorms EV3上に実装し、鏡像認知実験を行った。また、見真似行動を遺伝的アルゴリズムによって学習するプログラムのプロトタイプを制作した。

対話者のTweet履歴に基づく動的話題生成 : theramin

現状では対話者の任意の発話に対する適切な応答の生成は未だ困難である。システムによる話題の制 御は応答の生成を易化するが、対話者の積極性を損なう危険性がある。本研究では Tweet 履歴から対話者 の話しやすい話題を推定及び誘導することで、話者の積極性と応答生成の易化の両立を目指す。

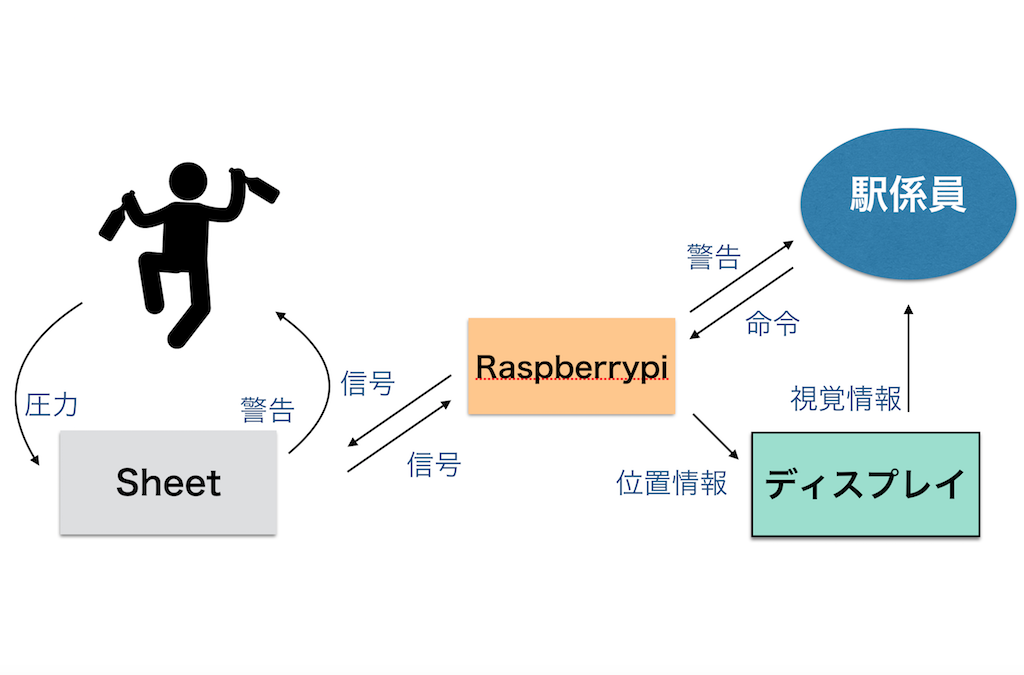

床デバイスによる酩酊者検知 : ramp

近年、駅のホームでの事故が多発しており、そのなかでも、酩酊者による事故が多発している。本研究では、酩酊者がホームから転落するのを防止するシステムの作成を目標にしている。今回はその第1歩となる研究として、床デバイスを用いた歩行者の検出を試みる。